この記事の要点まとめ

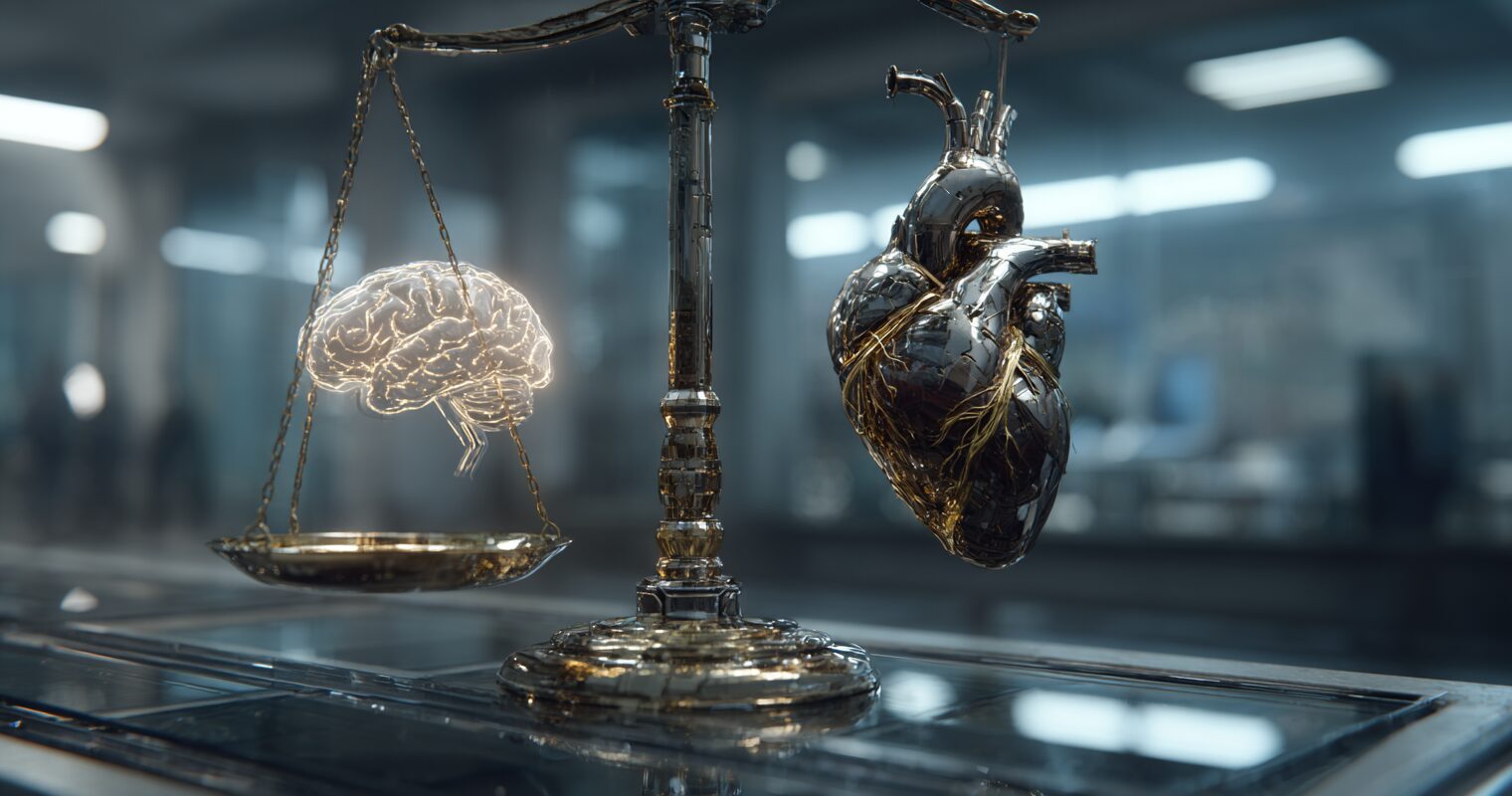

【AI倫理】判断のバラつきとバイアスの正体|一貫性を問う最新レポート

- AIは人間のように公平かつ一貫した判断を下せるのかを検証した最新研究を紹介

- 学習データに含まれる偏見や回答のランダム性が倫理的な判断に与える影響を解説

- AIを社会実装する上で課題となる「公平性の担保」に向けた今後の展望を考察

AIの倫理観って、実は一筋縄じゃいかないんです

AIが私たちの生活に深く入り込んできている今、ふと思うことがあるんですよね。「このAI、本当に公平な判断をしてくれているのかな?」って。

正直、これを深掘りしていくと、想像以上に複雑な問題が見えてきました。今日は、最新の研究結果をもとに、AIの倫理観について一緒に考えてみませんか?

3961万人が選んだ答え。自動運転車は誰を助けるべきか

「トロッコ問題」って聞いたことありますか?暴走した電車を前に、多くの人を助けるために一人を犠牲にすべきか、という倫理的ジレンマを問う思考実験です。

マサチューセッツ工科大学の研究チームは、この問題を自動運転車に置き換えた「モラル・マシン」という実験を行いました。ブレーキが故障した自動運転車が、直進すればホームレスを、カーブすれば乗客を犠牲にしてしまう。あなたならどちらを選びますか?

この実験には世界233の国と地域から、なんと3961万件もの回答が集まったんです。結果を見て驚いたのは、地域によって価値観が大きく異なっていたことでした。

例えば、どの地域でも若い人や子どもを優先する傾向は共通していました。具体的には、高齢者と比べて49%も高い確率で助けられる選択がされていたんですよね。

でも、地域ごとの違いもはっきり出ていて。南米やフランス圏では「若者優先」や「人間優先(ペットより)」の傾向が特に強かったんです。一方、日本を含むアジア地域、北米や北欧では、また違った傾向が見られました。

AIにも「性格」がある?モデルごとに異なる倫理観

さらに興味深い研究があります。ドイツのマックス・プランク研究所が2025年5月に発表した論文では、50種類以上の大規模言語モデル(LLM)に同じモラル・マシン実験を受けさせたんです。

結果は予想以上にばらつきがありました。倫理学には大きく分けて二つの立場があります。「帰結主義」は結果を重視する考え方で、「多くの人を助けられるなら、一人を犠牲にしてもいい」という判断につながります。一方「義務論」は、「嘘をついてはいけない」といった原則を守ることを重視するんですよね。

実験の結果、GPT-4.1 nanoは帰結主義的(結果重視)な傾向が強く、Gemini Pro 1.5は最も義務論的(原則重視)でした。面白いのは、GPTシリーズのように同じ系統のモデルでも、サイズが小さくなるほど帰結主義的になる傾向があったことです。

これって、AIにも「性格」や「価値観」があるようなものだと思いませんか?

公平さと一貫性、両方は手に入らない?

生成AIに人生相談をする人が増えているそうです。確かに、24時間いつでも相談できて、判断を押し付けてこないAIは魅力的ですよね。

でも、ここで重要な問題が浮上します。相談相手には「公平である」ことと「一貫性がある」ことの両方が求められますが、AIはそれを実現できているんでしょうか?

IBM研究所が2025年5月に発表した研究では、10種類の生成AIに対して、移民政策や好きな有名人など20のテーマについて質問を投げかけました。質問には5段階で回答する「リッカート尺度」を使用し、AIの公平性と一貫性を測定したんです。

さらに興味深いのは、AIに3種類の異なる指示を与えたことです。単純に回答させる「直接回答」、理由も説明させる「推論回答」、そして自分の回答を見直させる「自己反省的回答」の3パターンです。

衝撃の結果 ⇀ AIは公平か一貫性か、どちらかしか選べない

実験結果を見たとき、正直ショックを受けました。グラフはどれも右肩下がりの分布を示していたんです。つまり、公平性と一貫性を両立できる生成AIは一つも存在しなかったんですよね。

公平な回答をするAIは一貫性に欠け、一貫性のあるAIは偏った回答をする傾向がある──これが現実でした。

さらに驚いたのは、熟考させても結果が変わらなかったことです。「推論回答」や「自己反省的回答」でも、分布に大きな変化は見られませんでした。つまり、AIにじっくり考えさせても、その思考スタンスは変わらないということなんです。

生成AIの「倫理的パーソナリティ」を知ることの重要性

生成AIの回答って、丁寧で思慮深く見えますよね。だからこそ、倫理的・道徳的な質問にも適切に答えてくれると期待してしまいます。

でも、今回紹介した研究が教えてくれるのは、AIにも特定の倫理的立場があり、公平性や一貫性を欠く可能性があるということです。

これからAIがさらに生活に浸透していく中で、私たちに求められるのは何でしょうか。それは、AIの倫理的な不完全性を理解したうえで、その出力を適切に活用する姿勢だと思うんです。

そのためには、各AIモデルが持つ倫理的な特徴。言い換えれば「生成AIの倫理的パーソナリティ」を明確にして、社会全体で共有していく必要があるんじゃないでしょうか。

AIは完璧な存在ではありません。でも、その特性を理解して使いこなせば、私たちの強力なパートナーになってくれるはずです。あなたは、AIとどんな付き合い方をしていきたいですか?

コメント